在AI浪潮席卷各行各业的今天,如何快速、安全地将人工智能能力融入企业内部工作流,已成为提升效率与创新力的关键。公有云AI服务虽方便,但数据安全、模型隐私和网络隔离是企业无法回避的痛点。

Dify 作为一款开源的LLM应用开发平台,其强大的工作流功能和开箱即用的特性,让它成为构建企业内部AI应用的绝佳选择。而通过私有化部署,企业可以在完全自主可控的环境中,安全、高效地搭建AI应用开发平台。

本文将手把手带你完成Dify的私有化部署,并展示如何利用它快速搭建一个企业内部工作流。

一、为什么选择私有化部署Dify?

数据安全与隐私保障:所有数据(包括API密钥、应用数据、对话记录)都保存在您自己的服务器上,杜绝第三方泄露风险。

模型自主可控:支持对接企业内部部署的私有模型(如GPT、Ollama、本地部署的Llama 3等),也可安全地使用OpenAI、Azure等商业模型API。

网络隔离:部署在内网环境,满足金融、政务、医疗等对网络隔离有严格要求的场景。

定制化开发:基于开源代码,企业可以进行二次开发,深度定制符合自身业务需求的功能。

成本优化:长期来看,对于高频使用场景,私有化部署可以有效控制API调用成本。

二、Dify私有化部署实战(基于Docker Compose)

前置条件:

一台服务器(Linux,推荐4核CPU/8GB内存/100GB硬盘及以上配置)

Docker & Docker Compose 已安装

Python 3.10+(如需从源码安装则需要)

部署步骤:

步骤 1:获取部署文件从Dify官方GitHub仓库获取最新的docker-compose配置文件。

curl -O https://raw.githubusercontent.com/langgenius/dify/main/docker/docker-compose.yaml

curl -O https://raw.githubusercontent.com/langgenius/dify/main/docker/.env.example -o .env

步骤 2:配置环境变量编辑 .env 文件,这是配置Dify的核心。关键配置项如下:

设置数据库密码

POSTGRES_PASSWORD=your_strong_password_here

设置Redis密码

REDIS_PASSWORD=your_strong_password_here

非常重要!设置访问Dify的域名或IP,用于回调和服务访问。

APP_URL=http://your-server-ip:80

加密密钥,请使用openssl rand -base64 42生成并替换

SECRET_KEY=your_generated_secret_key_here

模型配置(示例:使用OpenAI,也可配置Azure、Ollama等)

OPENAI_API_KEY=sk-your-openai-api-key-here

步骤 3:启动Dify服务使用docker-compose一键启动所有服务(Web前端、API后端、数据库、Redis等)。

docker-compose up -d

步骤 4:访问并初始化在浏览器中输入你的服务器IP(如 http://your-server-ip),即可看到Dify的初始化界面。按照提示创建第一个管理员账户。

至此,一个完整的企业级Dify AI开发平台就已经部署完成!

三、快速搭建一个企业内部工作流示例:智能IT客服工单分类

假设我们需要一个AI应用,能自动将员工提交的IT工单内容进行分类并分配给相应的处理组。

-

创建应用与工作流在Dify控制台,点击“创建应用”,选择“工作流”类型,命名为“IT工单智能分类”。

-

设计工作流节点通过拖拽的方式,构建如下工作流:

开始节点 -> LLM推理节点(提取工单关键信息) -> 代码节点(根据LLM输出,匹配预定义的分类规则) -> HTTP请求节点(调用企业内部工单系统的API,创建已分类的工单) -> 结束节点。

3. 配置关键节点

LLM推理节点:编写提示词,例如:“你是一个IT专家。请分析以下用户输入的工单内容,并提取出问题类型(如:网络故障、软件安装、硬件损坏、账号密码)、紧急程度(高/中/低)和主要问题摘要。以JSON格式输出。”

代码节点:编写一段Python代码,将LLM输出的JSON结果,映射到具体的IT处理团队ID。

HTTP请求节点:配置内网工单系统创建接口的URL、认证信息和请求体,将分类结果传递过去。

4. 测试与发布输入一段测试工单内容,如“我的电脑无法连接Wi-Fi,急!下午有重要会议”,运行工作流查看每一步的结果。测试无误后,即可发布该应用。

- 集成到内部系统将发布后的应用API端点集成到企业微信、飞书、钉钉或内部办公系统中。员工在聊天窗口或表单中提交问题,即可瞬间完成工单的自动分类与创建,极大提升IT服务效率。

四、更多企业级应用场景

人力资源:搭建智能简历筛选工作流,自动提取简历信息并与JD匹配。

知识库问答:连接企业内部Wiki、Confluence,构建一个能回答公司政策、技术文档的智能客服。

数据分析:通过工作流自动查询数据库,并用LLM生成自然语言的分析报告。

内容创作:自动生成营销邮件、产品介绍、社交媒体帖子等,并交由负责人审核发布。

总结

通过私有化部署Dify,企业不仅获得了数据安全性和模型灵活性,更是拥有了一个强大的AI应用创新基础设施。其直观的“工作流”设计器让即便不懂代码的业务专家也能参与到AI应用的构建中,真正实现了AI技术的民主化。

现在就动手部署你的私有Dify平台,开启企业智能化转型的高速通道吧!

Dify技术学习交流群

推荐学习

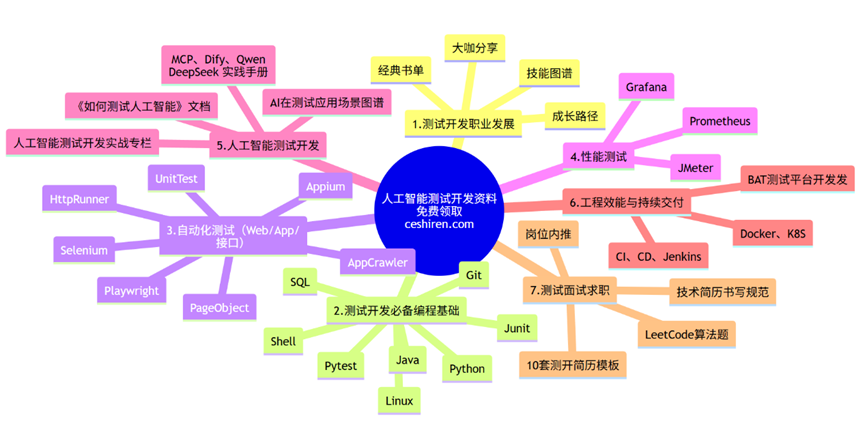

行业首个「知识图谱+测试开发」深度整合课程【人工智能测试开发训练营】,赠送智能体工具。提供企业级解决方案,人工智能的管理平台部署,实现智能化测试,落地大模型,实现从传统手工转向用AI和自动化来实现测试,提升效率和质量。